Suchwerkzeuge

| Welche Suchwerkzeuge gibt es?

Internetsuchdienste können nach verschiedenen Kriterien differenziert werden. Grundlegend unterscheidet man, ob es sich um eine manuell (von Menschen) erstellte Dokumentensammlung (z. B. Social Bookmark-Dienste, Internet-Verzeichnisse bzw. Webkataloge) oder auf der anderen Seite um ein rein maschinelles System (daher der Name "Suchmaschine"), d. h. algorithmenbasiertes automatisches System, handelt (z. B. große roboterbasierte Suchmaschinen, Metasucher). |

|

What sort of search tools are there anyway? |

Vorbemerkung

Manuell aufgebaute Link-Sammlungen waren der Beginn bei den Suchdiensten im WWW. Wir werden daher vorerst Linksammlungen/Internetverzeichnisse (in hierarchisch strukturierter Form auch Webkatalog genannt) sowie Social Bookmarkdienste für manuell erstellte Suchdienste erläutern. Große roboterbasierte Suchmaschinen und Metasuchmaschinen für rein maschinelle Systeme werden anschließend behandelt. Spezialsuchmaschinen gibt es für viele Anwendungsbereiche, sie sind, obwohl besonders interessant, eher wenig bekannt. Nachschlagewerke, Fachdatenbanken und Bibliothekskataloge sind weitere Suchdienste, im engeren Sinn aber keine Suchmaschinen. Große Bereiche des Internet werden von Datenbanken abgedeckt, die mit einer allgemeinen Suchmaschine nicht erreichbar sind („Deep Web“, „Invisible Web“). Es handelt sich hierbei in erster Linie um themenspezifische Datenbanken, die erst über Anfragen dynamische Webseiten generieren. Die Anfragen können über das Web gestellt werden, die Seiten werden aber von den Suchmaschinen nicht indiziert. Der größte Teil des „Deep Web“ ist kostenfrei zugänglich, es gibt aber auch eine Reihe von kostenpflichtigen Suchdiensten und Hosts. [1]

Linksammlungen / Internetverzeichnisse, Webkataloge

Schon frühzeitig sammelte man Adressen von Webseiten im WWW in einem Internetverzeichnis. In einfachster Form entstand eine Linkliste. In einem Internetverzeichnis werden die Internetseiten von Menschen aufbereitet. Eine Person oder ein ganzes Redaktionsteam wählt Internetseiten aus. Dabei wird die Internetseite meist einer Prüfung unterzogen. Nach bestandener Qualitätsprüfung wird die Seite im Internetverzeichnis unter einem oder mehreren Themengebieten gespeichert. Bei sehr umfangreichen Verzeichnissen hat sich eine hierarchische Gliederung der Themengebiete bewährt, man spricht dann von einem Webkatalog. Der älteste und sehr umfangreiche Webkatalog ist die Virtual Library (siehe http://vlib.org/). In manchen Verzeichnissen werden die Internetseiten auch bewertet, besonders "gute" Seiten werden z. B. mit einem Sternchen oder einer Lesebrille gekennzeichnet.

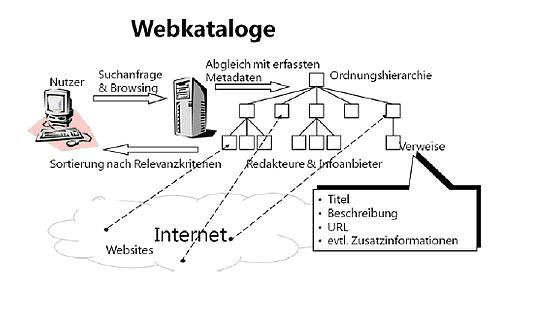

Folgende Abbildung illustriert den konzeptionellen Aufbau von Webkatalogen:

Abb. 1: Aufbau von Webkatalogen [2]

Web-Verzeichnisse spielen für den Zugang zu den Inhalten des Webs heute kaum mehr eine Rolle; sie wurden von den Suchmaschinen überrollt. Sie sollen hier trotzdem besprochen werden, da es sich einerseits um einen fundamental anderen Ansatz als den der Suchmaschinen handelt und die Web-Verzeichnisse andererseits vor allem in der Anfangszeit des Webs neben den Suchmaschinen der zweite wichtige Ansatz waren. [3]

Um nun eine Seite in einem Internetverzeichnis zu finden, können Sie sich entweder von einer Hauptkategorie bis zu einem Themengebiet durchklicken (das sogenannte Browsing) oder das Internetverzeichnis über eine eingebaute Suchmaschine durchsuchen.

Zusammenfassend sollen wesentliche Vor- und Nachteile von Internetverzeichnissen erläutert werden:[4]

Vorteile:

- Webkataloge eignen sich sehr gut für den Einstieg in bestimmte Themen und geben einen ersten Überblick in das Thema.

- Die redaktionelle Aufarbeitung sichert eine minimale Qualität der ausgewählten Webinhalte.

- Die Einteilung erfolgt durch thematische und hierarchische Prinzipien. Dadurch bieten Webkataloge Kontextinformationen.

- Oftmals erfassen Webkataloge eine Vielzahl von hochwertigen (Fach-)Datenbanken, deren Inhalte Suchmaschinen verschlossen bleiben.

Nachteile:

- Bei Webkatalogen fehlt oft ein standardisiertes Regelwerk für die Einordnung. Der hierarchische Aufbau ist von Webkatalog zu Webkatalog unterschiedlich.

- Die Katalogpflege ist sehr aufwändig, vor allem um die Inhalte zu erschließen und jeweils zu aktualisieren.

- Webkataloge decken nur einen Bruchteil des gesamten Webs ab.

Social Bookmarkdienste oder Tagging Communities

Mit dem Entwicklungstrend Web 2.0 wurden Social Bookmarkdienste populär. Social Bookmarks sind Lesezeichen, die mit Hilfe einer Browser-Oberfläche erschlossen werden. Diese Bookmarksammlungen werden von verschiedenen Benutzern gemeinschaftlich erstellt und können öffentlich gemacht und von anderen Nutzern eingesehen werden. Social Bookmarking ist ein mächtiges Werkzeug für die Recherche im Internet. Während allgemeine Suchmaschinen in der Regel zu viele Ergebnisse von teilweise bescheidener Qualität liefern, erbringt eine Suche in einem Social Bookmarking- Dienst nur Webseiten als Ergebnisse, die von Nutzern als so wertvoll erachtet wurden, dass sie der jeweiligen Bookmarksammlung hinzugefügt wurden. Auch bei der Recherche kann man von der aggregierten „Weisheit der Vielen“ profitieren. [5] Im Gegensatz zu einem Webkatalog geschieht das gemeinsame Indexieren der Links ohne strukturelle oder inhaltliche Vorgaben und Kontrolle. Das heißt, es existiert keine Ordnungshierarchie. Die Webseiten werden mit freien Schlagworten, so genannten Tags versehen, welche gesammelt eine Folksonomy bilden. Eine Tag-Cloud ist dann eine Visualisierung mehrerer Tags. Kommentierte Bookmarks, die frei verschlagwortet wurden, können dann anderen Benutzern zugänglich gemacht werden.

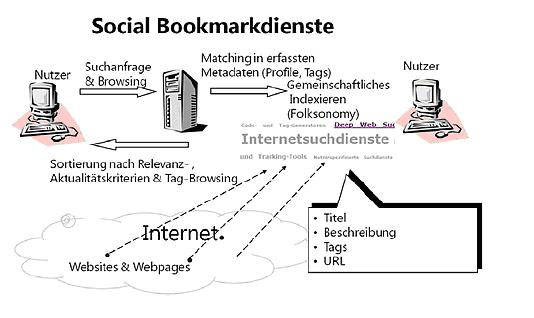

Folgende Abbildung zeigt die Funktionsweise der Social Bookmarkdienste:

Abb. 2: Aufbau von Social Bookmarkdienste [6]

Bekannte Social Bookmarkingdienst sind zum Beispiel:

- Delicious https://del.icio.us

- LinkArena https://linkarena.com

Überblick über populäre Social Bookmarking Websites:

- Top 15 Most Popular Social Bookmarking Websites http://www.ebizmba.com/articles/social-bookmarking-websites

Große roboterbasierte Suchmaschinen

Eine Suchmaschine besteht aus verschiedenen automatisch arbeitenden Programmen, die aufeinander abgestimmt sind und roboterbasierte Verfahren der Dokumentbeschaffung verwenden.

Wie funktioniert eine Suchmaschine?

"Suchmaschinen bestehen im Wesentlichen aus drei Komponenten. Die erste Komponente beschäftigt sich mit der Dokumentbeschaffung. Eine weitere Komponente dient der Inhaltserschließung sowie einer Komponente, welche die Ergebnismenge und deren Sortierung in Bezug zu den gestellten Suchanfragen determiniert." [7] Eine Suchmaschine durchsucht das Internet nicht dann, wenn der Benutzer eine Suchanfrage stellt. Bei den Milliarden von Dokumenten im Internet würde das viel zu lange dauern!

Folgende Beschreibung zur Funktionsweise einer Suchmaschine stammt von der umfangreichen Seite der Informationswissenschaft der Uni Konstanz.

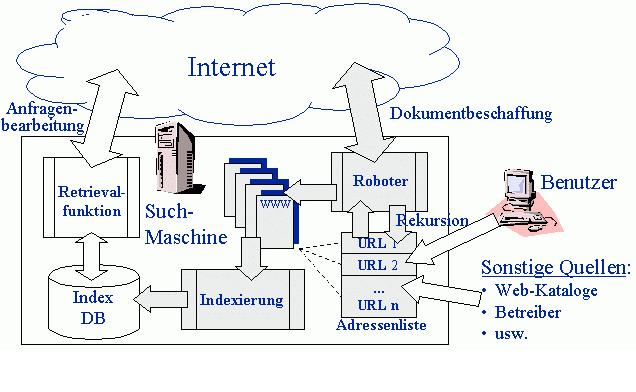

Der technische Aufbau einer Suchmaschine soll hier anhand einer schematischen Darstellung demonstriert werden:

Abb. 3: Systemaufbau einer Suchmaschine

Die Anfragenbearbeitung läuft zunächst als ein einfacher Zugriff auf eine Index-Datenbank ab. Der Nutzer gibt auf einem Web-Formular die Suchbegriffe ein, diese werden dann von der Suchmaschine abgearbeitet.

- Die Benutzerschnittstelle (Interface) ist das Formular und die Webseite, die der Benutzer sieht.

- Der Stichwortindex ist eine große Datenbank.

- Der Suchroboter durchstöbert dauernd das WWW und indexiert dabei gefundene Seiten, d. h. er nimmt die Seiten in einem Stichwortverzeichnis auf.

Ein Suchroboter beginnt seine Wanderung bei bekannten Web-Seiten und folgt dann allen Links, die er auf diesen Seiten findet. So "durchforscht" er immer größere Bereiche des Webs. Er analysiert dabei alle Seiten. Den Prozess nennt man Indexierung, die Datenbank der Suchmaschine nennt man auch Index. Der Suchroboter nimmt dabei alle Seiten, die er auf seinem Weg findet, in seinen Index auf. Mit Hilfe der Benutzersschnittstelle können Suchbegriffe eingegeben werden und die Ergebnisse werden aus der Indexdatenbank geliefert. Sie erhalten eine Liste mit Links zu weitern Webseiten, mittels unterschiedlicher Algorithmen wird, die zumeist unsinnig große Anzahl von Ergebnissen gereiht und bewertet.

Die einfache Handhabung der Suchmaschinen ist auch ein Grund warum sich viele Nutzer keine weiterern Gedanken über das Thema Internetrecherche machen.

Viele verlassen sich auf die Algorithmen von Google und vergessen dabei, dass diese Algorithmen auch eine gewisse Eigendynamik entwickeln können.

- Ist eine Webseite, beispielsweise weil es sie schon lange gibt, einmal für einen bestimmten Themenbereich und damit für entsprechende Suchabfragen etabliert, erscheint sie regelmäßig auf den vorderen Rängen der Ergebnislisten. Dadurch wird sie häufiger angeklickt und verlinkt, womit sich der Status weiter verbessert. Eine neue, vielleicht bessere Seite zum Thema hat vor diesem Hintergrund kaum eine Chance.

- Ein weiteres (potenzielles) Problem besteht darin, dass viele Suchmaschinen dazu übergegangen sind, die Suchergebnisse zu personalisieren. Anhand dessen, was Sie in der Vergangenheit gesucht haben und worauf Sie geklickt haben, wird das Ranking – die Reihenfolge der Suchergebnisse – angepasst. Außerdem wird häufig – beim mobilen Surfen metergenau per GPS – Ihr Standort berücksichtigt (Lokalisierung). Das kann sehr nützlich sein, führt aber dazu, dass die identische Suchabfrage bei verschiedenen Personen oder an verschiedenen Orten unterschiedliche Ergebnislisten erzeugt – ein Umstand, der den wenigsten Nutzern bewusst ist.

Die Personalisierung der Suche ist auch deshalb zutiefst ambivalent, weil es passieren kann, dass man in einen „Filter Bubble“ gerät. Ein Beispiel: Wenn Sie regelmäßig nach Suchanfragen zu politischen Themen stetig auf Seiten einer politischen Ausrichtung klicken, werden diese mit der Zeit höher gerankt. Mit anderen Worten: Sie erhalten zunehmend Antworten auf Ihre Suchabfragen, die Ihr Weltbild bestätigen.

Auf der einen Seite bietet das Internet Zugang zu einer unvorstellbaren Menge und Vielfalt an Informationen, auf der anderen Seite führen die Versuche, diese Informationen über Suchmaschinen (immer besser und bequemer) zugänglich zu machen, dazu, dass Ihnen die Vielfalt vorenthalten wird und Sie nur vorsortierte Ergebnisse zu sehen bekommen. Wer das nicht möchte, hat zwei Möglichkeiten. Erstens kann man die Personalisierung z. B. bei Google deaktivieren, zweitens kann man Suchmaschinen verwenden, deren Nische gerade darin besteht, auf Tracking und Personalisierung zu verzichten. Der im Moment erfolgversprechendste dieser Anbieter ist die Suchmaschine DuckDuckGo. [8]

Die bekanntesten großen internationalen Suchmaschinen:

- Google http://www.google.at

- Bing - Suchmaschine von Microsoft http://www.bing.com

- Yahoo! http://www.yahoo.com

- Baidu aus China https://www.baidu.com

Metasuchdienste & Metasuchmaschinen

Eine Metasuchmaschine ist eine Suchmaschine, die eine Suchanfrage gleichzeitig an mehrere Suchmaschinen und Kataloge weiterleitet, die Ergebnisse sammelt und entsprechend aufbereitet. Metasuchmaschinen brauchen daher keinen eigenen Index. Um zu sinnvollen Ergebnissen zu kommen, müssen doppelte Treffer, also solche, die bei mehreren Suchmaschinen gefunden werden, aussortiert werden. Zur Bewertung der Ergebnisse ist die Aufstellung eines eigenen internen Rankings notwendig. Die Ergebnisse werden dann einheitlich, wie in einer Suchmaschine, dargestellt. Die älteste Metasuchmaschine, die auch international einen hohen Bekanntheitsgrad hat, ist der Metacrawler. Der Metacrawler wurde vom Computer Science Departement der Universität von Washington entwickelt.

Grundsätzlich kann das Angebot durchsuchbarer Quellen erweitert werden. So nutzt die leistungsstarke Metasuchmaschine Yippy auch die freie Enzyklopädie Wikipedia, ebay sowie Weblogs und Nachrichtendienste. Weiters bietet diese Metasuchmaschine auch interessante Zusatzfunktionen wie ein Clustering der Ergebnisse.

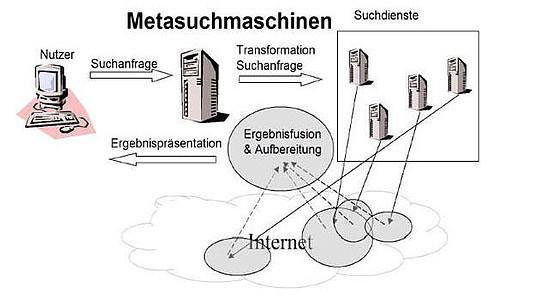

Eine einfache WWW-Seite mit mehreren Suchmasken verschiedener Suchmaschinen ist keine Metasuchmaschine. Die folgende Abbildung gibt die Funktionsweise von Metasuchdiensten wieder:

Abb. 5: Funktionsweise von Metasuchmaschinen [9]

Mit einer Metasuchmaschine spart man sich Zeit durch die gleichzeitige Suche in vielen verschiedenen Suchdiensten. Einschränkungen gibt es bei Suchfunktionen (kleinster gemeinsamer Nenner bei der Verwendung bestimmter Operatoren). Die Trefferqualität ist so gut wie die Trefferqualität der verwendeten Suchdienste, wobei noch berücksichtigt werden muss, dass nur eine eingeschränkte Anzahl von Treffern für die Metasuchmaschine verwendet werden kann. Schwierig ist das Ranking der gemischten Treffermenge. Da die Rankingwerte der einzelnen Suchdienste unterschiedlich und die Verfahren meist nicht offiziell bekannt sind, wird die Treffermenge meist nach den Suchdiensten gruppiert.

Metasuchdienste sind besonders gut geeignet für Informationsprobleme, bei denen man genau weiß, was man will. Bei sehr spezifischen Informationsanfragen weisen einzelne Suchdienste in der Regel nur wenige Treffer auf. Metasuchdienste bündeln diese Ergebnisse und beinhalten Suchdienste oder spezielle Datenbanken, die sonst nicht verbreitet bzw. bekannt sind.

Eine bekannte internationale Metasuchmaschine:

- Yippy http://yippy.com/

Eine deutsche Metasuchmaschine:

- Metager http://www.metager.de

Semantische Suche

Die semantische Suche ermöglicht eine Eingabe der Suchanfrage in natürlicher Sprache. Stark strukturierte und formalisierte Eingaben, wie sie unter Suchstrategien beschrieben sind, sollen dadurch unnötig gemacht und die Suche so wesentlich erleichtert werden. Diese Art der Suche ist allerdings noch nicht sehr weit verbreitet und hauptsächlich für die englische Sprache verfügbar.

Wolfram Alpha [10] ist ein typisches Beispiel für eine solche Suchmaschine und erlaubt den natürlichsprachigen Zugriff auf eine große Wissensbasis mit Schwerpunkt auf den exakten Wissenschaften. Auch bei Google sind semantische Ansätze integriert, Suchabfragen wie "Wann geht die Sonne auf" oder "100 EUR in USD" liefern passende Antworten. In beiden Fällen wird nicht das gesamte Web durchsucht, sondern versucht, die Antwort auf die Anfrage algorithmisch zu finden. Hierbei wird die Sucheingabe per NLP (Natural Language Processing) analysiert und die extrahierten Schlüsselworte dann zur Suche verwendet.

Die an SQL angelehnte Abfragesprache SPARQL ermöglicht es, Dokumente im semantischen Web abzufragen und miteinander zu verknüpfen. Eine solche Schnittstelle bietet beispielsweise DBpedia [11], eine semantisch angereicherte Version von Wikipedia.

Spezialsuchmaschinen und Suchmaschinenverzeichnisse

Spezialsuchmaschinen sind eine interessante Ergänzung einer großen allgemeinen Suchmaschine. Durch die Einschränkung auf ein bestimmtes Themengebiet oder auf Dokumentenmerkmale (z. B. Datentyp) gelingt es in der Regel besser, für eine bestimmte Zielgruppe genauere Ergebnisse zu erzielen. Dieser Bereich wird dann häufig vollständiger indexiert als von einer allgemeinen Suchmaschine. Spezialsuchmaschinen bieten häufig auch mehr Suchmöglichkeiten an, die auf diesen Bereich optimiert sind. In einer Spezialsuchmaschine für Filme gibt es z. B. die Möglichkeit, direkt nach Filmtiteln, Regisseuren, Schauspielern oder Charakteren zu suchen. Spezialsuchmaschinen eignen sich daher besonders gut, wenn sie nur einen bestimmten Bereich im Internet durchsuchen wollen. Beschäftigt man sich mit einem speziellen Thema, sind spezielle Verzeichnisse ein guter Einstieg in das jeweilige Thema. Für beinahe jedes Thema gibt es schon spezielle Suchverzeichnisse bzw. Suchmaschinen.

Grober Überblick Spezialsuchmaschinen

Es ist unmöglich, einen kompletten Überblick über die gesamte Landschaft der Spezialsuchmaschinen zu geben. Eine Hilfestellung dazu geben Verzeichnisse von Spezialsuchmaschinen, wie z.B. Searchenginewatch Specialty Search Engines http://searchenginewatch.com/article/2065024/Specialty-Search-Engines

Ein bekanntes internationales Verzeichnis:

- Beaucoup http://www.beaucoup.com

- Weitere Verzeichnisse http://einkauf.oesterreich.com/info/cat_detail.asp?cat=508

Ausgewählte Bereiche der Spezialsuche

Nachrichtensuchmaschinen

- Newssuche http://www.paperball.de

- Google News http://news.google.at

Personensuchmaschine

- Personensuche http://www.yasni.at

Weitere Beispiele:

- Techniksuchmaschine http://www.sjn.de

- Suchmaschine bzw. Datenbank für Filme, MovieDatabase http://www.imdb.com/

- Verzeichnisse von weltweiten Telefonbücher http://www.telefonbuch.com

- Fachzeitungen http://www.fachzeitungen.de/

- Archivsuchmaschine A digital library of internet sites http://www.archive.org

Suchmaschinenverzeichnisse - Suchmaschinen über Suchmaschinen

Deutschsprachige Suchmaschinenverzeichnisse:

- Die Suchmaschinen Datenbank - die Suchmaschinen-Liste http://www.suchmaschinen-datenbank.de/

Internationales Verzeichnis:

- Searchenginecolossus http://www.searchenginecolossus.com/

- This section of Search Engine Watch lists some top choices in various categories. http://searchenginewatch.com/static/guides

Datenbanken und Tools für wissenschaftliche Recherchen

Über das Internet sind verschiedene Datenbanken, zum Teil kostenlos, erreichbar, die für das wissenschaftliche Arbeiten notwendig sind. Ein empfehlenswerter Ausgangspunkt dafür ist die Digitale Bibliothek der Universitätsbibliothek Linz. Diese bietet unter http://www.jku.at/UB/content/e997/ den Zugang bzw. einen Link u.a. zu folgenden Datenbanken

- Katalogdatenbanken: Diese umfassen die Bestände der Bibliothek. Der Verbundkatalog umfasst weiters die Bestände der Bibliotheken des Österreichischen Bibliothekenverbundes.

- Die elektronische Zeitschriftenbibliothek (EZB) umfasst die Titel (nicht den Inhalt) von beinahe 20.000 Zeitschriften, die online verfügbar sind. Für jede Zeitschrift wird dargestellt, ob deren Inhalte a) generell online zugänglich sind, b) nur über das Universitätsnetz bzw. bestimmte Computer an der Universität (d. h. die Universität Linz hat eine Lizenz), oder c) nicht zugänglich sind (aber ev. sind die Abstracts für eine Suche verfügbar).

- Manche wissenschaftliche Verlage bieten eine Volltextsuchmöglichkeit und den Zugang zu ausgewählten bzw. allen Zeitschriftenartikeln an (z. B. die ScienceDirect Datenbank des Elsevier-Verlages http://www.sciencedirect.com).

- Möchte man eine Suche über Zeitschriften verschiedener Fachrichtungen und Verlage durchführen, gibt es wieder spezielle Datenbanken, die dies ermöglichen. Wie z. B. die INSPEC Datenbank für Naturwissenschaften. Diese sind ebenfalls online zugänglich. Idealerweise geben die Suchergebnisse an, ob ein gesuchter Artikel im Zeitschriftenbestand der betreffenden Bibliothek vorhanden ist.

Zum Vereinfachen der Organisation der gefundenen Literaturquellen ist das Programm EndNote ein De-Facto-Standard. Es ermöglicht nicht nur die Organisation der Literatur, sondern auch den direkten Zugang zu wissenschaftlichen Datenbanken, sodass eine Suchanfrage mehrmals verwendet werden kann. Für die Suche „im Internet“ (d.h. nicht unter Verwendung der erwähnten wissenschaftlichen Datenbanken) gibt es Programme, die die Verwendung von Suchmaschinen und die Organisation der Suchresultate wesentlich erleichtern, wie beispielsweise Copernic. Dieses Tool ermöglicht Suchstrategien, die mit der alleinigen Verwendung von (Meta-)Suchmaschinen (noch) nicht möglich sind. (Anmerkung: Von den in diesem Absatz beschriebenen Programmen sind voll funktionsfähige Trial-Versionen im Internet verfügbar.)

Ausgewählte wissenschaftliche Datenbanken und Suchmaschinen:

- Deutschsprachige Literatur für Wiwi, Sowi, Psychologie.. http://www.wiso-net.de/

- Fachportale - Liste der Virtuellen Fachbibliotheken und Fachportale http://vascoda.wordpress.com/fachportale/

- Directory of Open Acess Journals http://www.doaj.org/

- Google Scholar – durchsucht wissenschaftliche Server http://scholar.google.at/

- LLEK Wissenschaftliche Suchmaschinen http://www.llek.de

- Science Direct http://www.sciencedirect.com

Literatur

Quellen

- ↑ Dirk Lewandowski and Philipp Mayr, Exploring the Academic Invisible Web, in: Library Hi Tech, 2006, Volume 24, Issue 4, S. 529 – 539

- ↑ Griesbaum, J / Bekavac, B. / Rittberger, M., Typologie der Suchdienste im Internet, Heidelberg 2009, S. 19

- ↑ vgl. Dirk Lewandowski, Suchmaschinen verstehen, Heidelberg, 2015, S. 24

- ↑ http://sprint.informationswissenschaft.ch/allgemeine-suche/suchverfahren/katalog-verzeichnis/ (08.09.2016)

- ↑ R. Müller, J. Plieniner, C. Rapp, Recherche 2.0, Wiesbaden, 2013, S. 37

- ↑ Griesbaum, J / Bekavac, B. / Rittberger, M., Typologie der Suchdienste im Internet, Heidelberg 2009, S.25

- ↑ vgl. Griesbaum, J / Bekavac, B. / Rittberger, M., Typologie der Suchdienste im Internet, Heidelberg, 2009, S. 28

- ↑ R. Müller, J. Plieninger, C. Rapp, Recherche 2.0, Wiesbaden, 2013, S. 26

- ↑ Griesbaum, J / Bekavac, B. / Rittberger, M., Typologie der Suchdienste im Internet, Heidelberg, 2009, S. 44

- ↑ http://www.wolframalpha.com

- ↑ http://dbpedia.org

- ↑ Katzlinger Elisabeth und Robert Zlabinger, Suche im Internet, in Skriptum Informationsverarbeitung 1, Manfred Pils (Hrsg.), 10. Auflage März 2008, S. 140 f.

Zitiervorschlag

Blasi / Illetits-Motta / Zlabinger in Höller, Informationsverarbeitung, Suchwerkzeuge (mussswiki.idb.edu/ivwiki)